Les LLM sont morts : Longue vie aux agents !

L’intelligence artificielle a franchi un cap décisif avec l’essor fulgurant de ChatGPT, ce qui a révolutionné aussi bien le grand public que les entreprises. Pourtant, face aux limites des modèles géants, une nouvelle approche émerge : les agents intelligents. Capables d’agir et d’interagir avec leur environnement numérique, ils redéfinissent l’avenir de l’IA en passant de la simple génération de texte à l’exécution de tâches concrètes et autonomes.

ChatGPT : une révolution technologique et une adoption fulgurante

Il y a quelques années à peine, interagir avec une intelligence artificielle relevait de la science-fiction aux yeux du grand public. Mais lorsqu’à la fin de l’année 2022 ChatGPT fait son apparition, une évolution radicale a lieu. Fondé sur le modèle GPT-3.5 et accessible gratuitement en ligne, ChatGPT a connu une ascension fulgurante, atteignant ainsi les 100 millions d’utilisateurs mensuels en seulement deux mois, un record historique pour une application grand public.

En comparaison, des services comme TikTok ont mis près de 9 mois à atteindre une telle audience. Tout en démocratisant la génération de texte par IA, ChatGPT a permis aux non-spécialistes d’expérimenter la puissance des grands modèles de langage, aussi appelés Large Language Models ou LLM. Des écoliers aux ingénieurs professionnels, chacun a pu poser des questions, obtenir des résumés, créer du code et générer des idées de contenu, via une conversation informatique en langage naturel.

Les retombées dans le monde professionnel ont été tout aussi marquantes. Plusieurs entreprises ont rapidement intégré ces modèles au sein de leurs produits et de leurs workflows. OpenAI a ainsi généré près d’un 1 milliard de dollars de revenu en 2023, jusqu’à atteindre les 3,7 milliards en 2024. Cette ascension fut soutenue par le développement d’API IA et de licences commerciales. La contraction de partenariats majeurs, tel qu’avec Microsoft, ont permis d’inclure l’usage de ChatGPT dans le quotidien des utilisateurs (moteurs de recherche, suites bureautiques), amplifiant encore son impact.

GPT-3.5 a été un véritable point de bascule. L’IA pouvait à présent rédiger un texte cohérent sur demande. GPT-4, créé au début de l’année 2023 a permis d’affirmer l’aspect révolutionnaire du logiciel en améliorant notamment ses capacités de raisonnement et de prise en compte d’images. En un temps record, l’IA générative textuelle est passée d’une curiosité de laboratoire à un outil grand public incontournable, à la fois pour les utilisateurs les moins aguerris mais aussi pour les entreprises en quête d’automatisation.

Des modèles toujours plus puissants, mais des progrès limités

Cependant cette ascension fulgurante fut remise en cause par l’évolution des modèles géants. En effet les acteurs majeurs du web tels qu’Open IA et ses concurrents (Anthropic, Google, Meta, Grok aux États Unis, Mistral en France, Deepseek et Qwen en Chine) ont œuvré à l’augmentation de la puissance de leurs LLM dès l’année 2024. Ainsi, de nouveaux records de performance et d’intelligence ont été établis au prix d’importants efforts et de coûts massifs.

Néanmoins, les gains tendent à plafonner par rapport aux sauts spectaculaires initiaux . En effet, selon les « scaling laws » ou lois d’échelle, chaque nouvelle nécessite désormais une augmentation exponentielle des ressources (taille des modèles, données utilisées, puissance de calcul), ce qui limite progressivement la marge de progression réelle des intelligences artificielles. De fait, doubler l’intelligence d’un modèle ne multiplierait pas le coût initial par deux mais plutôt par dix ou par cent : il faudrait à la fois plus de puissance de calcul et plus de données d’entraînement.

Là où le passage de GPT-3 à GPT-4 avait apporté un net progrès (GPT-4 réussissant par exemple environ 40 % mieux que GPT-3.5 sur certains examens académiques standard), le prochain modèle d’OpenAI (nom de code Orion) n’offrirait selon certaines sources que des améliorations minimes par rapport à GPT-4.

Cette dynamique de rendements décroissants touche l’ensemble du secteur : Google aurait constaté que son modèle Gemini 2.0 n’atteint pas les objectifs escomptés, et Anthropic aurait même temporairement mis en pause le développement de son LLM principal pour revoir sa stratégie. En bref, l’épuisement des grands corpus de données d’entraînement de haute qualité, ainsi que les difficilement soutenables coûts en puissance de calcul et en énergie nécessaire à l’amélioration des modèles, font qu’on atteint une sorte de plafond technique, du moins temporairement.

Les nouvelles approches : raisonnement et performances ciblées

Les chiffres le confirment sur les benchmarks. Les scores de compréhension multitâches (MMLU) des meilleurs modèles convergent : depuis 2023, presque tous les LLM atteignent des performances similaires sur ces tests, signe que l’on s’approche d’un palier. Même des modèles open-source bien plus petits commencent à rivaliser avec les géants entraînés par des investissements de milliards de dollars.

La course à l’énormité des modèles montre donc ses limites, et les géants de l’IA changent de stratégie : Sam Altman (OpenAI) a déclaré que la voie vers une IA vraiment intelligente ne viendra sans doute plus d’un simple scaling des LLM, mais d’un usage créatif des modèles existants. En clair, il s’agit de trouver de nouvelles approches pour gagner en intelligence sans simplement multiplier la taille des réseaux de neurones.

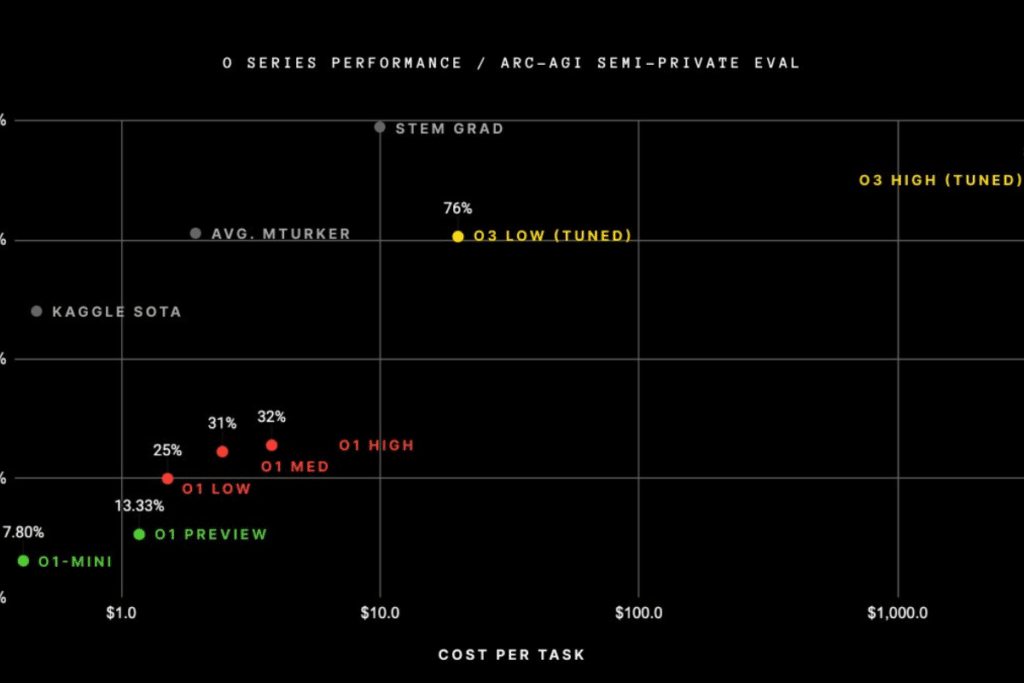

Certaines techniques, comme le Chain-of-Thought (ou le Tree-of-Thought), permettent au modèle de générer un « raisonnement » (on parle souvent de « thinking » modèles) avant de donner sa réponse, dans lequel il peut explorer des possibilités, se rendre compte de son erreur… C’est l’apanage des modèles o1, o3 d’OpenAI, de R1 de Deepseek, du mode « Think » de Grok… Cette méthode offre des gains d’intelligence remarquable, notamment sur les problèmes mathématiques.

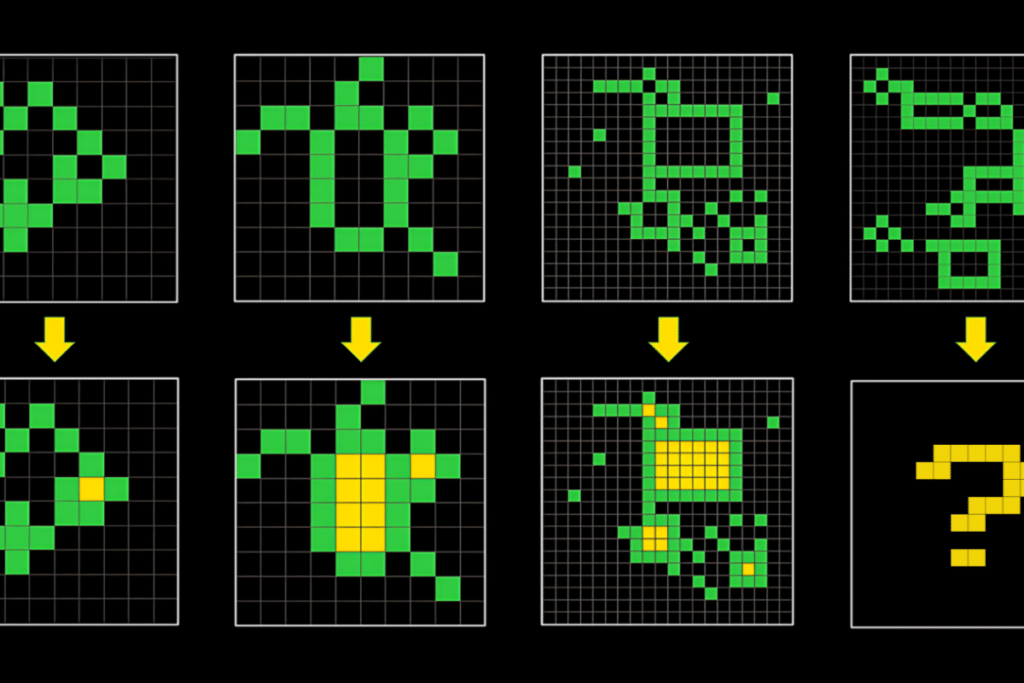

Cependant elle a tout de même un coût : l’un des grands benchmark pour tester l’intelligence des modèles est le ARC-AGI (« Abstract and Reasoning Corpus for Artificial General Intelligence »), publié par François Chollet en 2019, teste l’intelligence des modèles sur des tâches de généralisation comme celle ci-dessous :

Ce benchmark est resté très longtemps un défi trop difficile pour la totalité des modèles généraux, et il a fallu 4 ans pour passer de 0 % de complétion avec GPT-3 à 5 % avec GPT-4o. Mais en décembre dernier, OpenAI, en décembre dernier, publiait les résultats de sa gamme de modèles o3, avec un modèle spécialisé sur le ARC-AGI à 88% de complétion :

Cependant, chaque problème coûte avec ce modèle plus de 3000 $ d’exécution (sans compter les frais d’entraînement), et lui prend plus d’une dizaine de minutes.

L’ère des agents intelligents : de la théorie à l’action

La limite des LLM géants est désormais évidente. Plutôt que d’accumuler des milliards de paramètres, pour des gains en intelligence toujours plus faibles, l’industrie de l’IA préfère maintenant la doter « bras et jambes » pour passer de la simple génération de texte à l’action concrète. Désormais, l’IA ne se contente plus de répondre à des questions ou de générer du contenu de façon passive, mais se connecte d’elle-même à des bases de données, déclenche des API, et exécute des actions : faire une recherche sur internet, écrire du code et l’exécuter, réserver un vol, passer un appel…

Il est clair que cette nouvelle approche transforme radicalement notre rapport à la technologie. Ce changement de paradigme permet aux entreprises de repenser leurs workflows et d’utiliser la puissance des LLMs pour automatiser des tâches pénibles et répétitives. Cette approche modulaire mise sur une intelligence d’interaction plutôt que sur la brute force paramétrique. Le véritable enjeu est donc désormais de permettre à l’IA de collaborer avec d’autres systèmes pour obtenir des résultats concrets. Plusieurs agents intelligents illustrent déjà le potentiel disruptif de cette approche :

- DeepResearch, une des formes d’agent les plus connues, lancée d’abord par Google Deepmind (décembre 2024), puis openAI (février 2025) suivi de Perplexity et xAI. Cet agent parcourt le web, analyse des centaines de sources et compile un rapport complet en quelques minutes. Pour un journaliste ou un analyste, c’est un gain de temps phénoménal qui transforme la veille et la synthèse d’information ;

- Perplexity, offre par ailleurs une recherche d’information avancée en synthétisant des données issues de multiples sources et en fournissant des réponses complètes et sourcées, dépassant largement la simple liste de résultats que proposent les moteurs de recherche traditionnels ;

- Manus, incarne le stagiaire numérique par excellence. Capable de décomposer une tâche complexe en sous-étapes, il organise un voyage, compare des offres ou compile des données financières de bout en bout, illustrant parfaitement comment l’IA peut passer de la théorie à l’action ;

- v0, par Vercel révolutionne le développement web. En transformant des idées exprimées en langage naturel en code fonctionnel, il permet de prototyper et de déployer des sites ou dashboards en un temps record, rendant accessible la création d’applications même aux non-experts ;

- GitHub Copilot, Cursor, Claude Code, redéfinissent la programmation en suggérant du code en temps réel, en détectant les erreurs et en les corrigeant automatiquement. Ils font passer le rôle du développeur de simple rédacteur de code à celui de superviseur stratégique.

Anthropic, createur de Claude, publiait d’ailleurs il y a quelques mois un nouveau standard, le Model Context Protocol (ou MCP) qui devrait in fine permettre la connexion entre un LLM compatible et des “serveurs” d’outils choisi par l’utilisateur. Cette approche a déjà fait beaucoup de bruit dans la communauté. Certains comme siddharth ahuja (@sidahuj) sur X (anciennement Twitter) s’en servant par exemple pour connecter Claude a Blender, le logiciel de modélisation 3D, et générer des scènes juste avec des requêtes :

Vers un futur modulaire et interactif de l’intelligence artificielle

L’arrivée de ces agents marque un tournant décisif dans notre interaction avec l’IA. En permettant à une intelligence artificielle de passer à l’action, on assiste à une transformation des méthodes de travail. Les entreprises qui intègrent des agents dans leurs systèmes peuvent automatiser des processus complexes, réduire les délais et améliorer la précision des opérations, qu’il s’agisse de synthétiser de vastes volumes d’informations ou de piloter des applications complètes.

Pour les professionnels, l’impact est immédiat. Un analyste peut désormais déléguer la recherche et la compilation d’informations à Deep Research, libérant ainsi du temps pour l’analyse stratégique. Un développeur, aidé par v0, peut concrétiser une idée en quelques minutes, tandis que GitHub Copilot accélère la production de code et réduit les erreurs. Les possibilités sont déjà immenses, et continuent d’augmenter au fur et à mesure que de nouveaux agents sont créés.

Au-delà du milieu professionnel, ces agents vont également transformer notre quotidien, en se glissant dans nos outils personnels et rendent accessibles des services autrefois réservés aux experts : il est aujourd’hui beaucoup plus facile de « photoshoper » une image, de générer du code pour un algorithme complexe, d’obtenir un rapport détaillé sur un sujet…

Ainsi, l’ère des LLM géants touche peut-être à sa fin, tandis que l’arrivée des agents AI ouvre une nouvelle ère d’innovation. Ces agents – Deep Research, Manus, v0 by Vercel, GitHub Copilot, Cursor, Perplexity AI, et bien d’autres – semblent en tout cas démontrer que la véritable valeur de l’IA réside dans sa capacité à orchestrer plusieurs outils pour accomplir des tâches complexes, gagner du temps et transformer nos workflows.

Mais au-delà de ces succès concrets, une question demeure : que nous réserve l’avenir de l’IA ? À quelles innovations s’attendre ? Peut-être une intégration encore plus poussée avec l’edge computing, ou des agents capables d’apprendre en temps réel, ou encore des écosystèmes modulaires permettant à chacun de personnaliser son assistant numérique ? Ce qui est sûr, c’est que nous ne sommes encore qu’au début de cette révolution, qui sera peut-être la plus grande que l’humanité connaîtra. Et vous, êtes-vous impatients de découvrir Orion (GPT5), Claude 4, Llama 4, DeepHeek R2, et d’autres innovations disruptives ? Quel outil de ce futur vous enthousiasme le plus ?

Maximisez votre expérience Cointribune avec notre programme 'Read to Earn' ! Pour chaque article que vous lisez, gagnez des points et accédez à des récompenses exclusives. Inscrivez-vous dès maintenant et commencez à cumuler des avantages.

Rayan Drissi CTO of multiple crypto projects, including a token that reached a $90M market cap. Founder of a development agency with a team of 10 developers specializing in Web3, AI, and full-stack development. Graduate of one of the top 3 computer science schools in France, and recently awarded the prestigious “Pépite de France” status, recognizing the best student entrepreneurs in the country through a highly selective program.

Les propos et opinions exprimés dans cet article n'engagent que leur auteur, et ne doivent pas être considérés comme des conseils en investissement. Effectuez vos propres recherches avant toute décision d'investissement.