La evolución de la IA : Los agentes inteligentes llegan para quedarse

La inteligencia artificial ha alcanzado un hito decisivo con el ascenso vertiginoso de ChatGPT, lo que ha revolucionado tanto al gran público como a las empresas. Sin embargo, frente a las limitaciones de los modelos gigantes, surge un nuevo enfoque: los agentes inteligentes. Capaces de actuar e interactuar con su entorno digital, redefinen el futuro de la IA al pasar de la simple generación de texto a la ejecución de tareas concretas y autónomas.

ChatGPT : una revolución tecnológica y una adopción vertiginosa

Hace apenas unos años, interactuar con una inteligencia artificial era cosa de ciencia ficción a los ojos del gran público. Pero cuando, a finales de 2022, ChatGPT hizo su aparición, tuvo lugar una evolución radical. Basado en el modelo GPT-3.5 y accesible gratuitamente en línea, ChatGPT ha tenido un ascenso vertiginoso, alcanzando así los 100 millones de usuarios mensuales en solo dos meses, un récord histórico para una aplicación de consumo.

En comparación, servicios como TikTok tardaron casi 9 meses en alcanzar tal audiencia. Al democratizar la generación de texto por IA, ChatGPT ha permitido a los no especialistas experimentar el poder de los grandes modelos de lenguaje, también llamados Large Language Models o LLM. Desde escolares hasta ingenieros profesionales, todos han podido hacer preguntas, obtener resúmenes, crear código y generar ideas de contenido, a través de una conversación informática en lenguaje natural.

Las repercusiones en el mundo profesional han sido igualmente notables. Varias empresas han integrado rápidamente estos modelos en sus productos y flujos de trabajo. OpenAI generó así casi 1 mil millones de dólares en ingresos en 2023, alcanzando hasta 3.7 mil millones en 2024. Este ascenso se vio respaldado por el desarrollo de API de IA y licencias comerciales. La creación de asociaciones importantes, como con Microsoft, ha permitido incluir el uso de ChatGPT en la vida diaria de los usuarios (motores de búsqueda, suites de oficina), amplificando aún más su impacto.

GPT-3.5 ha sido un verdadero punto de inflexión. La IA ahora podía redactar un texto coherente a pedido. GPT-4, creado a principios de 2023, permitió afirmar el aspecto revolucionario del software al mejorar especialmente sus capacidades de razonamiento y procesamiento de imágenes. En un tiempo récord, la IA generativa de texto pasó de ser una curiosidad de laboratorio a una herramienta indispensable para el público en general, tanto para los usuarios menos experimentados como para las empresas en busca de automatización.

Modelos cada vez más potentes, pero progresos limitados

Sin embargo, este ascenso vertiginoso fue cuestionado por la evolución de los modelos gigantes. De hecho, los actores principales de la web, como Open IA y sus competidores (Anthropic, Google, Meta, Grok en Estados Unidos, Mistral en Francia, Deepseek y Qwen en China) han trabajado para aumentar la potencia de sus LLM desde el año 2024. Así, se han establecido nuevos récords de rendimiento e inteligencia a costa de esfuerzos significativos y costos masivos.

No obstante, las ganancias tienden a estabilizarse en comparación con los primeros saltos espectaculares. De hecho, según las “leyes de escalado”, cada novedad requiere ahora un aumento exponencial de recursos (tamaño de los modelos, datos utilizados, potencia de cálculo), lo que limita progresivamente el margen de mejora real de las inteligencias artificiales. De hecho, duplicar la inteligencia de un modelo no multiplicaría el costo inicial por dos, sino más bien por diez o por cien: se requerirían tanto más potencia de cálculo como más datos de entrenamiento.

Mientras que la transición de GPT-3 a GPT-4 presentó un claro avance (GPT-4 logró aproximadamente un 40 % mejor que GPT-3.5 en ciertos exámenes académicos estándar), el próximo modelo de OpenAI (código Orion) ofrecería, según algunas fuentes, solo mejoras mínimas en comparación con GPT-4.

Esta dínamica de rendimientos decrecientes afecta a todo el sector: Google habría observado que su modelo Gemini 2.0 no cumple con los objetivos esperados, y Anthropic incluso habría pausado temporalmente el desarrollo de su LLM principal para revisar su estrategia. En resumen, el agotamiento de los grandes cuerpos de datos de entrenamiento de alta calidad, así como los costos difíciles de sostener en potencia de cálculo y energía necesarios para mejorar los modelos, han llevado a alcanzar una especie de límite técnico, por lo menos de forma temporal.

Nuevos enfoques : razonamiento y rendimiento específico

Las cifras lo confirman en los benchmarks. Las puntuaciones de comprensión multitarea (MMLU) de los mejores modelos convergen: desde 2023, casi todos los LLM alcanzan un rendimiento similar en estas pruebas, señal de que nos acercamos a un límite. Incluso modelos de código abierto mucho más pequeños comienzan a rivalizar con los gigantes entrenados con inversiones de miles de millones de dólares.

La carrera hacia la grandeza de los modelos muestra por lo tanto sus limitaciones, y los gigantes de la IA cambian de estrategia: Sam Altman (OpenAI) ha declarado que la vía hacia una IA realmente inteligente probablemente no vendrá de un simple escalado de los LLM, sino de un uso creativo de los modelos existentes. En claro, se trata de encontrar nuevos enfoques para ganar en inteligencia sin simplemente multiplicar el tamaño de las redes neuronales.

Ciertas técnicas, como el Chain-of-Thought (o el Tree-of-Thought), permiten al modelo generar un “razonamiento” (a menudo se habla de “models thinking”) antes de dar su respuesta, en el que puede explorar posibilidades, darse cuenta de su error… Es el apanaje de los modelos o1, o3 de OpenAI, de R1 de Deepseek, del modo “Think” de Grok… Este método ofrece mejoras en la inteligencia notables, especialmente en problemas matemáticos.

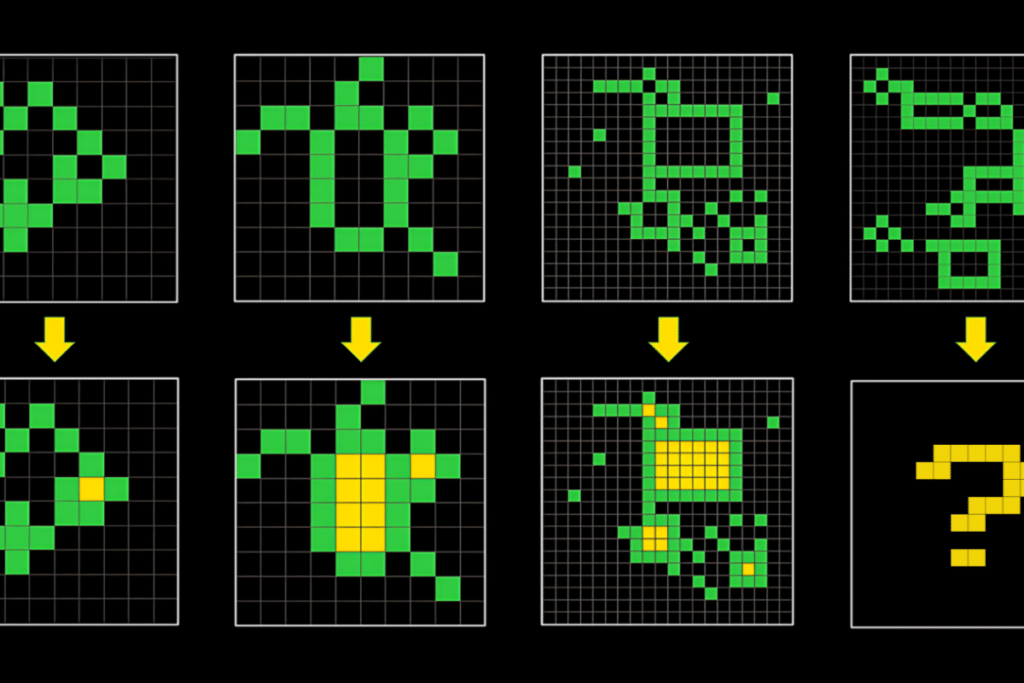

Sin embargo, todavía tiene un costo: uno de los grandes benchmarks para probar la inteligencia de los modelos es el ARC-AGI (“Abstract and Reasoning Corpus for Artificial General Intelligence”), publicado por François Chollet en 2019, que testea la inteligencia de los modelos en tareas de generalización como la siguiente :

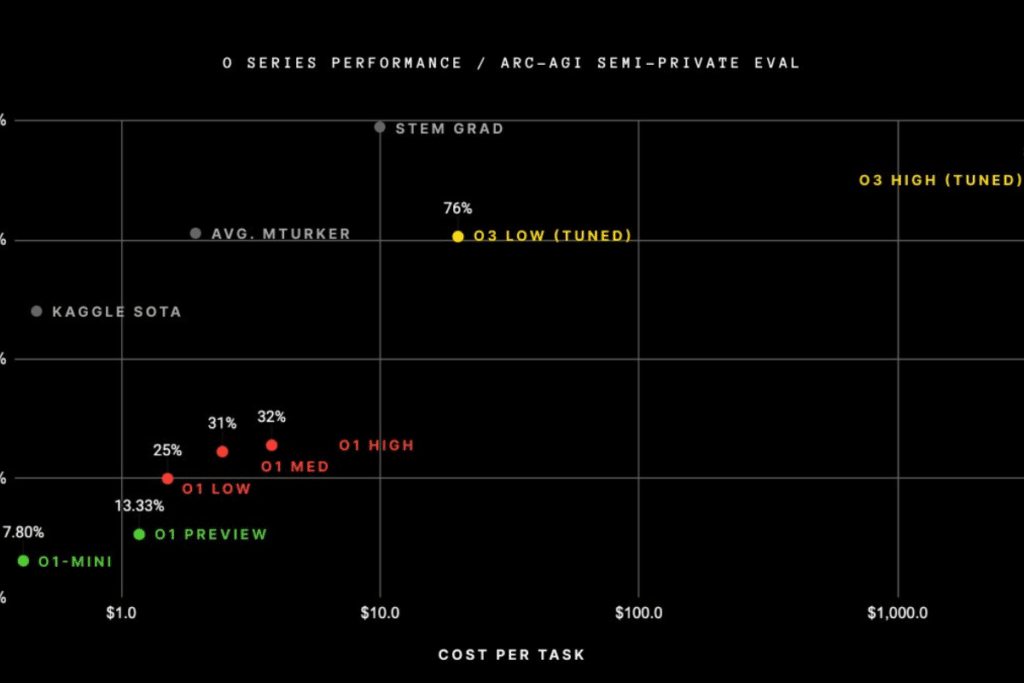

Este benchmark ha permanecido durante mucho tiempo como un desafío demasiado difícil para la totalidad de los modelos generales, y se necesitó 4 años para pasar del 0 % de completación con GPT-3 al 5 % con GPT-4o. Pero en diciembre pasado, OpenAI, en diciembre pasado, publicó los resultados de su gama de modelos o3, con un modelo especializado en el ARC-AGI con un 88 % de completación :

Sin embargo, cada problema cuesta con este modelo más de 3000 $ por ejecución (sin contar los costos de entrenamiento), y le lleva más de diez minutos.

La era de los agentes inteligentes: de la teoría a la acción

El límite de los LLM gigantes es ahora evidente. En lugar de acumular miles de millones de parámetros, para obtener ganancias en inteligencia cada vez más débiles, la industria de la IA prefiere ahora dotarla de «brazos y piernas» para pasar de la simple generación de texto a la acción concreta. Ahora, la IA no se limita a responder preguntas o generar contenido de forma pasiva, sino que se conecta por sí misma a bases de datos, desencadena APIs y ejecuta acciones: realizar una búsqueda en internet, escribir código y ejecutarlo, reservar un vuelo, hacer una llamada…

Está claro que este nuevo enfoque transforma radicalmente nuestra relación con la tecnología. Este cambio de paradigma permite a las empresas repensar sus flujos de trabajo y utilizar el poder de los LLMs para automatizar tareas tediosas y repetitivas. Este enfoque modular se basa en una inteligencia de interacción en lugar de en la fuerza bruta paramétrica. El verdadero desafío es, por lo tanto, permitir que la IA colabore con otros sistemas para obtener resultados concretos. Varios agentes inteligentes ya ilustran el potencial disruptivo de este enfoque:

- DeepResearch, una de las formas de agente más conocidas, lanzada primero por Google Deepmind (diciembre de 2024), luego por OpenAI (febrero de 2025) seguida de Perplexity y xAI. Este agente recorre la web, analiza cientos de fuentes y compila un informe completo en minutos. Para un periodista o analista, es un ahorro de tiempo fenomenal que transforma la vigilancia y la síntesis de información ;

- Perplexity, ofrece además una búsqueda de información avanzada al sintetizar datos de múltiples fuentes y proporcionar respuestas completas y referenciadas, superando con mucho la simple lista de resultados que ofrecen los motores de búsqueda tradicionales ;

- Manus, encarna al becario digital por excelencia. Capaz de descomponer una tarea compleja en subtareas, organiza un viaje, compara ofertas o compila datos financieros de principio a fin, ilustrando perfectamente cómo la IA puede pasar de la teoría a la acción ;

- v0, por Vercel revoluciona el desarrollo web. Al transformar ideas expresadas en lenguaje natural en código funcional, permite prototipar y desplegar sitios o paneles en un tiempo récord, haciendo accesible la creación de aplicaciones incluso para los no expertos ;

- GitHub Copilot, Cursor, Claude Code, redefinen la programación al sugerir código en tiempo real, detectar errores y corregirlos automáticamente. Hacen que el rol del desarrollador pase de ser un simple redactor de código a un supervisor estratégico.

Anthropic, creador de Claude, publicó de hecho hace unos meses un nuevo estándar, el Model Context Protocol (o MCP) que debería in fine permitir la conexión entre un LLM compatible y “servidores” de herramientas elegidas por el usuario. Este enfoque ya ha causado mucho revuelo en la comunidad. Algunos como siddharth ahuja (@sidahuj) en X (anteriormente Twitter) lo utilizan, por ejemplo, para conectar Claude a Blender, el software de modelado 3D, y generar escenas solo con solicitudes :

Hacia un futuro modular e interactivo de la inteligencia artificial

La llegada de estos agentes marca un giro decisivo en nuestra interacción con la IA. Al permitir que una inteligencia artificial pase a la acción, estamos presenciando una transformación en los métodos de trabajo. Las empresas que integran agentes en sus sistemas pueden automatizar procesos complejos, reducir plazos y mejorar la precisión de las operaciones, ya sea para sintetizar vastos volúmenes de información o para gestionar aplicaciones completas.

Para los profesionales, el impacto es inmediato. Un analista puede ahora delegar la búsqueda y la compilación de información a Deep Research, liberando así tiempo para el análisis estratégico. Un desarrollador, asistido por v0, puede concretar una idea en unos pocos minutos, mientras que GitHub Copilot acelera la producción de código y reduce errores. Las posibilidades ya son enormes y continúan aumentando a medida que se crean nuevos agentes.

Más allá del ámbito profesional, estos agentes también transformarán nuestra vida cotidiana, al integrarse en nuestras herramientas personales y hacer accesibles servicios que antes estaban reservados a expertos: hoy en día es mucho más fácil “photoshopear” una imagen, generar código para un algoritmo complejo, obtener un informe detallado sobre un tema…

Así, la era de los LLM gigantes podría estar llegando a su fin, mientras que la llegada de los agentes de IA abre una nueva era de innovación. Estos agentes – Deep Research, Manus, v0 by Vercel, GitHub Copilot, Cursor, Perplexity AI, y muchos más – parecen demostrar que el verdadero valor de la IA radica en su capacidad para orquestar múltiples herramientas para realizar tareas complejas, ahorrar tiempo y transformar nuestros flujos de trabajo.

Pero más allá de estos éxitos concretos, una pregunta persiste: ¿qué nos depara el futuro de la IA? ¿Qué innovaciones podemos esperar? Tal vez una integración aún más profunda con el edge computing, o agentes capaces de aprender en tiempo real, o ecosistemas modulares que permitan a cada uno personalizar su asistente digital? Lo que es seguro es que todavía estamos al principio de esta revolución, que podría ser la más grande que la humanidad haya conocido. ¿Y tú, estás ansioso por descubrir Orion (GPT5), Claude 4, Llama 4, DeepHeek R2, y otras innovaciones disruptivas? ¿Qué herramienta de este futuro te entusiasma más?

¡Maximiza tu experiencia en Cointribune con nuestro programa "Read to Earn"! Por cada artículo que leas, gana puntos y accede a recompensas exclusivas. Regístrate ahora y comienza a acumular beneficios.

Rayan Drissi CTO of multiple crypto projects, including a token that reached a $90M market cap. Founder of a development agency with a team of 10 developers specializing in Web3, AI, and full-stack development. Graduate of one of the top 3 computer science schools in France, and recently awarded the prestigious “Pépite de France” status, recognizing the best student entrepreneurs in the country through a highly selective program.

Las ideas y opiniones expresadas en este artículo pertenecen al autor y no deben tomarse como consejo de inversión. Haz tu propia investigación antes de tomar cualquier decisión de inversión.